Documentos del BIS | No. 145 | 23 de mayo de 2024

Por: Iñaki Aldasoro, Sebastian Doerr, Leonardo Gambacorta, Sukhvir Notra, Tommaso Oliviero y David Whyte

Texto completo en formato PDF (222kb) | 22 páginas

La inteligencia artificial generativa (IAG) presenta nuevas oportunidades para fortalecer la ciberseguridad de los bancos centrales, pero también presenta nuevos riesgos. Utilizamos datos de una encuesta única entre expertos en ciberseguridad de los principales bancos centrales para arrojar luz sobre estas cuestiones. Las respuestas revelan que la mayoría de los bancos centrales ya han adoptado o planean adoptar herramientas de IAG en el contexto de la ciberseguridad, ya que los beneficios percibidos superan los riesgos. Los expertos prevén que las herramientas de IA mejorarán la detección de amenazas cibernéticas y reducirán el tiempo de respuesta a los ciberataques. Sin embargo, la IAG también aumenta los riesgos de ataques de ingeniería social y divulgación de datos no autorizados. Para mitigar estos riesgos y aprovechar los beneficios de la IAG, los bancos centrales anticipan la necesidad de inversiones sustanciales en capital humano, especialmente en personal con experiencia tanto en ciberseguridad como en programación de IA. Por último, si bien los encuestados esperan que la IAG automatice varias tareas, también esperan que apoye a los expertos humanos en otras funciones, como la supervisión de los modelos de IA.

Clasificación JEL: E58, G20, G28, K24

Palabras clave: inteligencia artificial, ciberseguridad, bancos centrales, capital humano

Sobre los autores

1. Introducción

Los ciberataques se han vuelto más frecuentes y sofisticados, y el sector financiero se sitúa sistemáticamente como una de las industrias más atacadas (Aldasoro et al (2020, 2022)). Los bancos centrales representan un objetivo natural para los ciberataques, ya que son responsables de la gestión y supervisión de las infraestructuras críticas del sector financiero (por ejemplo, los sistemas de pago) y salvaguardan la información confidencial sobre futuras decisiones políticas (Doerr et al (2022)). Reforzando estas preocupaciones, en marzo de 2024 un informe del Departamento del Tesoro de EE. UU. destacó la inteligencia artificial generativa (gen AI) como un aspecto crítico emergente para la ciberseguridad del sector financiero.

La aparición de modelos de IA en generación, que cobró un impulso significativo con el lanzamiento de ChatGPT a finales de 2022, presenta tanto oportunidades como desafíos para la gestión del riesgo cibernético en el sector financiero, incluidos los bancos centrales. Por un lado, a medida que las herramientas de IA de generación se vuelven más sofisticadas y su uso se generaliza, la frecuencia y la velocidad de los ataques cibernéticos aumentarán. También es probable que estos ataques se vuelvan más complejos, debido a algoritmos más refinados. Las amenazas específicas incluyen ingeniería social generada por IA, ataques de día cero y ataques de malware para la fuga de datos. La adopción de la IA genérica para fines de organización interna y, potencialmente, también para la ciberdefensa también crea el riesgo de ataques directos contra los sistemas de IA. Por otro lado, la IA de generación puede fortalecer la seguridad cibernética al permitir el procesamiento de conjuntos de datos cada vez más grandes con análisis más sofisticados. También podría ayudar a los usuarios a emplear estrategias más proactivas de ciberseguridad y prevención del fraude.

A la luz de estos avances, es de suma importancia comprender el impacto de la IA en la gestión del riesgo cibernético de los bancos centrales. Esta cuestión está naturalmente entrelazada con las habilidades del personal del banco central. De hecho, establecer reglas de conducta y garantizar una comprensión profunda de los riesgos y beneficios asociados con el uso de herramientas de IA de generación para todos los empleados es esencial para mantener altos estándares de seguridad cibernética. Además, la cuestión de si el desarrollo de herramientas de IA complementará o reemplazará la experiencia humana en las unidades de TI de los bancos centrales sigue siendo objeto de un debate en curso.

Para investigar el vínculo entre la generación de IA y el riesgo cibernético, nos basamos en los resultados de una encuesta ad hoc realizada entre los miembros del Grupo Global de Resiliencia Cibernética (GCRG) en enero de 2024. El GCRG es una de las iniciativas del Centro de Coordinación de la Resiliencia Cibernética (CRCC).3 Establecido en 2020, el GCRG sirve como un foro donde los directores de seguridad de la información (CISO) de los bancos centrales se reúnen para discutir cuestiones tácticas y estratégicas relacionadas con la seguridad cibernética. La encuesta recopiló las respuestas de 32 participantes, profundizando en las oportunidades y desafíos que los bancos centrales ven en la adopción de herramientas de IA genérica. Cuatro consideraciones generales guiaron el diseño de la encuesta:

1) ¿Cuál es el estado actual de la adopción de la IA en generación por parte de los bancos centrales?

2) ¿Cómo evalúan los bancos centrales los beneficios y desafíos para la ciberseguridad asociados con el uso de la IA genérica?

3) ¿Qué tan preparados están los bancos centrales para la «revolución de la IA» y su impacto esperado en la seguridad cibernética y la protección de datos?

4) ¿Cuáles son las principales preocupaciones estratégicas, éticas y regulatorias con respecto a la adopción de la IA en la ciberseguridad?

Las respuestas de la encuesta revelan cuatro ideas principales.

En primer lugar, una gran mayoría de los bancos centrales informan que ya están utilizando herramientas de IA de generación o planean hacerlo en los próximos años. Los encuestados indican que la IA de generación ofrece más beneficios que riesgos, especialmente en lo que respecta a aspectos específicos de la ciberseguridad, como la detección de amenazas cibernéticas. Sin embargo, el proceso de adopción conlleva importantes desafíos, sobre todo en términos de inversión adecuada en capital humano. De hecho, más de la mitad de los expertos encuestados informan de que sus estrategias en relación con la evaluación y adopción de la estrategia de IA están actualmente en fase de desarrollo.

En segundo lugar, la opinión predominante es que la IA genérica puede superar a los métodos tradicionales para mejorar la gestión de la ciberseguridad, pero que también introduce nuevos riesgos. Los beneficios se perciben en gran medida en áreas específicas de la ciberseguridad, como la automatización de tareas rutinarias. Se espera que la IA reduzca los costos asociados con las actividades que consumen mucho tiempo y que tradicionalmente realizaban los humanos. Los beneficios adicionales de la IA de generación incluyen una detección de amenazas mejorada, tiempos de respuesta más rápidos a los ataques cibernéticos y aprendizaje de nuevas tendencias, anomalías o correlaciones que podrían no ser obvias para los analistas humanos. En términos de riesgos, la IA puede introducir nuevas vulnerabilidades en las defensas de ciberseguridad de los bancos centrales. Los riesgos relacionados con la ingeniería social y los ataques de día cero, así como la divulgación no autorizada de datos, son los más preocupantes.

En tercer lugar, nuestros resultados destacan aspectos clave en cuanto a inversiones en TI y capital humano. De la encuesta se desprenden dos dimensiones críticas con respecto al capital humano. El primero afecta a todos los empleados de los bancos centrales e implica la adopción de herramientas de IA de alta generación, que pueden verse obstaculizadas por la falta de habilidades tecnológicas. De hecho, la mayoría de los bancos centrales han habilitado o planean permitir que su personal acceda a aplicaciones de IA genérica basadas en la nube, aunque con ciertas restricciones de uso. Este enfoque tiene como objetivo mitigar los riesgos asociados con la adopción de la IA genérica, en particular en lo que respecta a la falta de preparación actual del personal para integrar y poner en funcionamiento los sistemas de IA. La segunda dimensión se relaciona con el capital humano acumulado en las divisiones de TI de los bancos centrales. Existe un consenso de que la IA de alta generación podría reemplazar al personal de las unidades de seguridad cibernética para las tareas rutinarias. Este cambio podría liberar recursos para reasignarlos a iniciativas de ciberseguridad más estratégicas, lo que podría aumentar la productividad. Además, las respuestas indican que, aunque la IA genérica se considera una tecnología que puede manejar las tareas operativas de manera más efectiva, aún requerirá supervisión humana para garantizar resultados éticos y precisos y entrenar continuamente los sistemas de IA. Por lo tanto, una preocupación general es la limitada disponibilidad de personal con suficientes conocimientos tanto de metodologías de IA como de ciberseguridad.

En cuarto lugar, el consenso entre los encuestados es que los sistemas de IA de generación facilitarán el cambio de un enfoque reactivo a uno proactivo para predecir y neutralizar las amenazas. Una consideración crítica es el grado de autonomía que se debe otorgar a las herramientas de IA en materia de ciberseguridad y la naturaleza de su interacción con los humanos. Para una estrategia adecuada, los científicos de datos, los analistas de seguridad de IA y los supervisores de IA se identifican como roles profesionales clave para la integración perfecta de la IA de generación con las herramientas de seguridad existentes.

Los resultados de este estudio contribuyen al debate en curso sobre la mejor manera de utilizar la IA para limitar el riesgo cibernético. Kashyap y Wetherilt (2019) proponen un conjunto de principios a tener en cuenta a la hora de regular el riesgo cibernético dentro del sector financiero. Además, el Comité de Supervisión Bancaria de Basilea (BCBS) ha publicado directrices para los bancos sobre las mejores prácticas en materia de gestión de riesgos cibernéticos (BCBS (2018, 2021)). Nuestros resultados sugieren que podrían ser necesarias medidas adicionales para tener en cuenta los beneficios y desafíos potenciales que surgen de la propagación de la IA gen. Además, dada la incertidumbre y la variabilidad significativas en las estimaciones de costos para los incidentes de seguridad cibernética, que podrían aumentar con la adopción futura de herramientas de IA, es deseable establecer pautas y prácticas comunes para todos los bancos centrales. Además, es posible que el personal de TI existente no esté completamente preparado para manejar las innovaciones rápidas y disruptivas asociadas con la IA genérica. La «brecha de habilidades» prevista puede ser difícil de cerrar para la mayoría de los bancos centrales, dada la limitada oferta de mano de obra y los altos costos asociados con las nuevas contrataciones.6 Abordar este problema es vital para los bancos centrales en el futuro.

Cada vez son más los trabajos que estudian el papel y el impacto de las ciberamenazas en el sector privado, incluidas las instituciones financieras y las criptomonedas (Boissay et al (2022)), pero pocos estudios han examinado las implicaciones para los bancos centrales. Una excepción es el trabajo de Doerr et al (2022), quienes analizan el tema del riesgo cibernético en la banca central aprovechando una encuesta ad hoc realizada en 2021. Nuestra contribución es ampliar el alcance de ese análisis ampliando la muestra de los bancos centrales participantes en la encuesta e incorporando nueva evidencia sobre la gestión de la seguridad cibernética, específicamente en lo que respecta a la relación entre el advenimiento de nuevas herramientas de IA y la preparación del personal de los bancos centrales para este avance tecnológico disruptivo.

Nuestro artículo también contribuye al debate más general sobre el impacto esperado de la introducción de herramientas de IA en la estructura organizativa de las empresas públicas y privadas. La literatura destaca un aumento esperado en la productividad laboral, especialmente en tareas que requieren habilidades cognitivas (Brynjolfsson et al (2023); Noy y Zhang (2023); Peng et al (2024)), aunque los efectos podrían ser bastante diferentes en todos los sectores (Felten et al (2021)). Este artículo profundiza en los efectos de la IA genérica en la productividad considerando la perspectiva de los expertos en ciberseguridad de los bancos centrales. Nuestros hallazgos subrayan que se espera que las herramientas de IA de generación mejoren la eficiencia de las prácticas de seguridad cibernética existentes, impulsando así la productividad de los profesionales, particularmente en tareas rutinarias y operativas. Al mismo tiempo, los expertos en ciberseguridad no esperan que sus funciones sean sustituidas por aplicaciones de IA de generación; más bien, se otorga una importancia cada vez mayor a la participación humana en las tareas relacionadas con la supervisión y la capacitación de las actividades impulsadas por la IA, lo que garantiza resultados éticos y precisos.

El resto del documento está organizado de la siguiente manera: La sección 2 proporciona contexto sobre los desarrollos recientes en la IA de generación y cómo puede afectar a la seguridad cibernética. En la sección 3 se presentan los resultados de la encuesta relativa a la adopción de la IA por parte de los bancos centrales. En la sección 4 se analizan las oportunidades, los riesgos y los desafíos percibidos asociados a la adopción de herramientas de IA genérica para la gestión de la ciberseguridad. En la sección 5 se examinan las respuestas a las preguntas sobre la inversión en tecnologías de la información y el capital humano. En la sección 6 se analiza el panorama futuro y se proporcionan algunas perspectivas normativas. Concluye la sección 7.

2. La IA genérica y el riesgo cibernético

La IA de generación puede verse como el último avance del aprendizaje automático. A grandes rasgos, el aprendizaje automático comprende un conjunto de técnicas diseñadas para extraer información de los datos, con el fin de hacer predicciones. Puede verse como una consecuencia de las técnicas estadísticas y econométricas tradicionales, aunque no se basa en un modelo preespecificado o en supuestos estadísticos como la linealidad o la normalidad. El proceso de ajustar un modelo de aprendizaje automático a los datos se denomina entrenamiento. El criterio para un entrenamiento exitoso es la capacidad de predecir resultados a partir de datos no vistos previamente («fuera de la muestra»), independientemente de cómo los predigan los modelos.

Las redes neuronales son quizás la técnica más importante en el aprendizaje automático, con usos generalizados incluso para la última generación de modelos. Sus principales bloques de construcción son las neuronas artificiales, que toman múltiples valores de entrada y los transforman de forma no lineal para generar un solo número, como las regresiones logísticas. Las neuronas artificiales están organizadas para formar una secuencia de capas que se pueden apilar: las neuronas de la primera capa toman los datos de entrada y emiten un valor de activación. A continuación, las capas siguientes toman la salida de la capa anterior como entrada, la transforman y generan otro valor, y así sucesivamente. De esta manera, al igual que las neuronas en el cerebro humano, el valor de salida de una neurona artificial es similar a un impulso eléctrico transmitido a otras neuronas. La profundidad de una red se refiere al número de capas. Los pesos y sesgos que determinan la fuerza de las conexiones entre las neuronas y las capas se denominan colectivamente parámetros. Estos parámetros se mejoran de forma iterativa durante el entrenamiento. Las redes más profundas con más parámetros requieren más datos de entrenamiento, pero predicen con mayor precisión. Las redes neuronales están detrás del reconocimiento facial o de los asistentes de voz como Siri o Alexa y son la base de las innovaciones recientes más significativas en IA.

Transformers, presentado en 2017, mejoró drásticamente el rendimiento de las redes neuronales en el procesamiento del lenguaje natural (NLP) y permitió el surgimiento de grandes modelos de lenguaje (LLM). En lugar de limitarse a relacionar una palabra con los que están cerca de ella, los transformadores intentan captar la relación entre los diferentes componentes de una secuencia de texto, incluso si están muy alejados en el párrafo o documento. Esto permite que el modelo comprenda mejor el contexto y, por lo tanto, los diferentes significados que puede tener una palabra. Por ejemplo, el significado de la palabra «banco» difiere cuando aparece en la oración «Cruzaré el río a nado para llegar a la otra orilla» frente a «Crucé la calle para ir al banco». Transformers desbloqueó casos de uso de procesamiento de lenguaje natural que requieren lidiar con largos flujos de texto y dio lugar a los avances más recientes en LLM, como ChatGPT. La disponibilidad de grandes cantidades de texto digitalizado de Internet y los rápidos avances en la potencia informática han permitido a los LLM basados en transformadores alcanzar habilidades similares a las humanas en el procesamiento del lenguaje.

Los LLM subyacen en el rápido auge de la IA de la generación, que genera contenido basado en indicaciones adecuadas y puede realizar tareas más allá del reconocimiento del idioma. En particular, puede generar contenido nuevo, desde texto e imágenes hasta música y código, en función de los datos con los que se han entrenado.7 Por ejemplo, los LLM como ChatGPT (Generative Pretrained Transformer) están diseñados para predecir la siguiente palabra o token. Al ingerir el rastreo común en su conjunto de entrenamiento, presentan capacidades de aprendizaje de disparo cero y pueden responder a las indicaciones humanas para generar texto de una manera que imite el lenguaje humano. Por lo tanto, permiten una amplia gama de tareas lingüísticas, redacción de ensayos, codificación de software e incluso participar en conversaciones matizadas.

Se espera que la IA de generación sea la próxima tecnología de propósito general, con el potencial de transformar varias industrias y tener un impacto significativo en la economía (McKinsey (2023), Aldasoro et al (2024a)). Los bancos centrales no son una excepción. De hecho, en el pasado reciente, los bancos centrales han implementado con éxito herramientas tradicionales de IA para diversas aplicaciones, incluidas técnicas de aprendizaje automático para el análisis de datos, la supervisión de sistemas de pago, la supervisión y la ciberseguridad (Araujo et al (2022, 2024); Doerr et al (2021)).

La adopción de la IA genérica por parte de los bancos centrales ofrece nuevas oportunidades y desafíos relacionados con la gestión de la ciberseguridad. La IA de generación se puede aplicar tanto en el lado ofensivo como en el defensivo del riesgo cibernético (Neupane et al (2023)). A continuación, informaremos sobre las principales áreas de riesgo introducidas por el uso ofensivo de modelos de IA de generación, así como las implicaciones para la defensa cibernética y la configuración de estrategias destinadas a contrarrestar el aumento de las amenazas cibernéticas inducidas por la IA de generación.

El desarrollo de herramientas de IA de generación podría mejorar las capacidades de los actores de amenazas cibernéticas sofisticados y permitir que los actores menos hábiles desarrollen ataques simples pero efectivos.8 Los usos de la IA de generación por parte de los actores de amenazas cibernéticas para la fuga de datos o los ataques incluyen:

i) 7 Técnicas de ingeniería social: Los actores de amenazas pueden utilizar los LLM para llevar a cabo ataques de phishing más específicos, compromiso del correo electrónico empresarial, deepfakes y otros fraudes. Por ejemplo, la IA genérica permite a los actores de amenazas tergiversarse a sí mismos de manera más realista como reflejo de una variedad de orígenes, idiomas, estados y géneros.

ii) Generación de malware/código: La IA puede ayudar a crear nuevos códigos de malware o variantes más complejas de los existentes que pueden evadir de manera más efectiva un sistema de detección automatizado basado en firmas.

iii) Desinformación: La IA genérica puede aumentar la eficiencia de un ataque dirigido mediante la realización de campañas de desinformación utilizando características y personalidades más realistas del lenguaje humano.

Además, la adopción de herramientas de IA para las operaciones internas y la ciberdefensa genera el riesgo de ataques contra los propios sistemas de IA (Zhu et al (2024)). Estos riesgos incluyen:

i) Envenenamiento de datos/modelos: Es el proceso de corromper los datos de entrenamiento del modelo interno de la IA gen para perjudicar el proceso de entrenamiento u obtener un resultado deseado (Improta (2024)).

ii) Fuga de datos durante la inferencia: Los actores de amenazas pueden obtener acceso a datos confidenciales a través de la inversión del modelo y la consulta programática del modelo durante la fase de inferencia.

iii) Descubrimiento de vulnerabilidades: Los actores de amenazas pueden utilizar herramientas basadas en IA que normalmente se utilizan para la defensa cibernética para descubrir vulnerabilidades e identificar debilidades en la red de una institución.

Por último, la dependencia de los sistemas de IA de los datos puede amplificar los desafíos existentes en relación con la seguridad y la privacidad de los datos, incluida la información relacionada con terceros. Los aspectos financieros, legales y de seguridad críticos incluyen la evaluación de si los datos de entrenamiento son propietarios, cómo se manejan, recopilan y preparan los datos, y la calidad de los datos de entrenamiento.

En general, el auge de la IA gen amplificará los riesgos cibernéticos existentes y creará nuevos desafíos. Pero esta innovadora tecnología también se puede utilizar en el lado de la defensa para fortalecer la ciberseguridad y ayudar a emplear estrategias de prevención del fraude más proactivas. Estas estrategias abarcan diversas técnicas como la detección, el engaño y el ataque adversario. Como veremos a continuación, la adecuada capacidad de programación de IA del personal de TI y la disponibilidad de datos para el entrenamiento y las pruebas son fundamentales para cosechar los beneficios de la IA para la ciberseguridad.

3. La IA de la generación en la banca central

A continuación, presentamos los resultados de la encuesta realizada entre los miembros del GCRG en enero de 2024. Comenzamos evaluando el estado actual de la adopción de la IA en los bancos centrales. Más de dos tercios (71%) de los encuestados ya están utilizando la IA de generación, y el 26% tiene planes de incorporar dichas herramientas en sus operaciones en los próximos uno o dos años.9 Por lo tanto, la tasa de adopción podría acercarse al 100% a corto plazo.

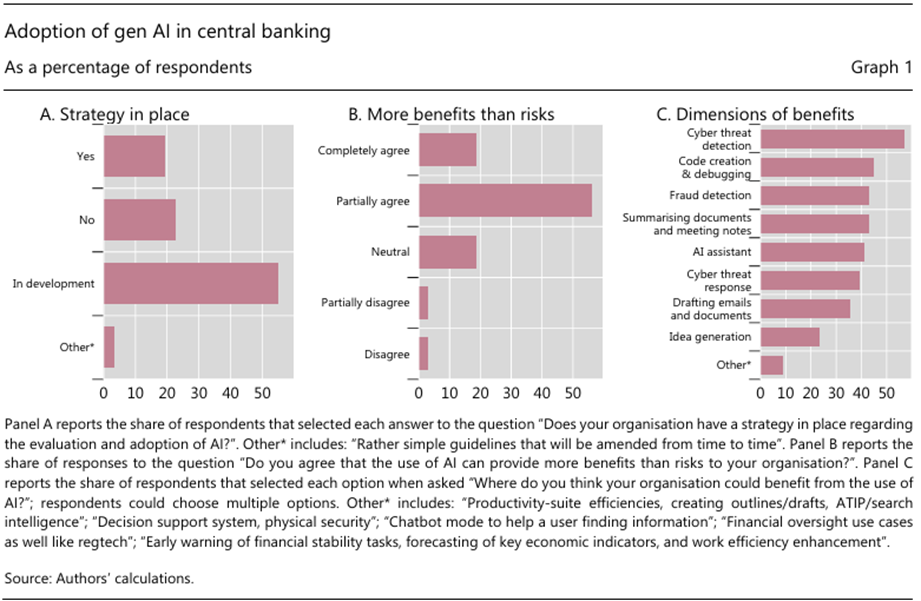

Sin embargo, los bancos centrales todavía están explorando la mejor manera de integrar esta tecnología. En concreto, cuando se les preguntó si tenían una estrategia concreta para adoptar e integrar la IA genérica, solo el 19% afirmó que sí, mientras que el 23% respondió que no tenía ninguna estrategia de este tipo (Gráfico 1.A). Una mayoría significativa (55%) indicó que su estrategia aún está «en desarrollo».

Este enfoque cauteloso puede atribuirse en parte a la incertidumbre existente sobre el uso correcto de la IA genérica. En la etapa actual, no solo se perciben oportunidades sustanciales, sino también riesgos y desafíos que requieren una comprensión adecuada antes de tomar medidas. Para una evaluación preliminar de las ventajas y desventajas percibidas, la encuesta pidió a los expertos de los bancos centrales que evaluaran si el uso de la IA proporcionará más beneficios que riesgos a sus organizaciones. Las respuestas, recogidas en el gráfico 1.B, son algo heterogéneas: el 19% está totalmente de acuerdo con la afirmación, el 56% está parcialmente de acuerdo, el 19% es neutral y el 6% está parcial o totalmente en desacuerdo. Estos hallazgos sugieren una inclinación general entre los bancos centrales a reconocer las ventajas (netas) de la IA genérica.

El gráfico 1.C muestra las dimensiones a lo largo de las cuales los bancos centrales perciben los beneficios de la IA genérica. «Detección de amenazas cibernéticas» es la dimensión elegida con más frecuencia, seleccionada por el 57% de los encuestados. Además, los bancos centrales creen que la «creación y depuración de códigos», la «detección de fraudes» y la «respuesta a las amenazas cibernéticas» también pueden beneficiarse de la implementación de la IA gen, aunque en menor grado. Estas respuestas ponen de manifiesto que los ciberataques son una grave preocupación para los bancos centrales. Otras dimensiones de los beneficios incluyen actividades que suelen incluirse en el trabajo diario de los empleados, como «Resumir documentos y notas de reuniones» (43% de los encuestados) y «Redactar correos electrónicos y documentos» (36% de los encuestados).

4. Oportunidades, riesgos y desafíos para la ciberseguridad

Un desafío clave para los bancos centrales es establecer una infraestructura de TI que pueda aprovechar de manera efectiva los beneficios de la IA genérica y, al mismo tiempo, abordar los riesgos cibernéticos actuales y previstos. Esta sección ofrece un análisis más detallado de las oportunidades (Sección 4.1), así como de los riesgos y desafíos (Sección 4.2) asociados con la adopción generalizada de la IA gen, según la percepción de los líderes encuestados dentro de las unidades de ciberseguridad de TI de los bancos centrales.

4.1 Oportunidades

Las herramientas tradicionales de aprendizaje automático para la gestión de riesgos cibernéticos han sido empleadas por los bancos centrales durante algún tiempo. Estas herramientas incluyen sistemas para detectar y responder a amenazas cibernéticas, proteger las transacciones y monitorear la integridad de los sistemas de pago.

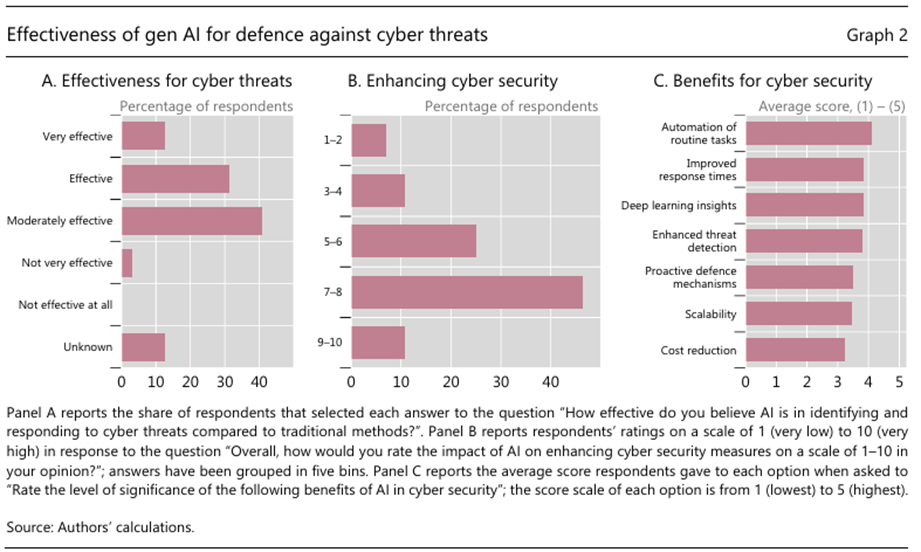

La IA de generación podría mejorar las capacidades de seguridad cibernética más allá de las capacidades de los métodos más tradicionales y contribuir a mejorar la seguridad cibernética en general. Cuando se les pidió explícitamente que evaluaran este aspecto, el 44% de los encuestados percibe que la IA genética es muy efectiva o efectiva, mientras que el 41% la considera moderadamente efectiva (Gráfico 2.A). Solo el 3% cree que la nueva tecnología no es muy efectiva, y el 13% se abstiene de proporcionar una evaluación. En línea con la pregunta anterior, la encuesta invitó a los bancos centrales a evaluar el impacto de la IA genética en la mejora de las medidas de ciberseguridad (gráfico 2.B). Utilizando una escala de 1 (mejora baja) a 10 (mejora alta), una cuarta parte de los encuestados la valoró entre 5 y 6, más del 45% entre 7 y 8 y el 11% la valoró entre 9 y 10, mientras que el 7% eligió un valor inferior o igual a 2. Por lo tanto, la capacidad percibida de la IA genérica para impulsar la ciberseguridad es, por lo tanto, ampliamente positiva, pero su impacto general sigue siendo algo incierto.

La evaluación mixta de los beneficios potenciales de la adopción de la IA en la ciberseguridad podría provenir de las diferentes áreas operativas en las que los expertos anticipan las ganancias más significativas. El gráfico 2.C ilustra las puntuaciones medias asignadas a las distintas facetas de la ciberseguridad que podrían beneficiarse de la IA, con puntuaciones en una escala de 1 (beneficios muy bajos) a 5 (beneficios muy altos). «Automatización de tareas rutinarias» recibió la puntuación media más alta, lo que indica que una ventaja clave del uso de herramientas de IA de generación radica en su capacidad para reemplazar las tareas intensivas en mano de obra que suelen realizar los humanos. Las siguientes dimensiones que reciben las puntuaciones más altas son «Tiempos de respuesta mejorados», «Deep learning insights» (refiriéndose al aspecto de aprendizaje profundo de la IA capaz de ofrecer información sobre las amenazas cibernéticas mediante el análisis de patrones de datos más allá de las capacidades humanas) y «Detección de amenazas mejorada». Esto subraya la creencia de que la IA genética tendrá un impacto positivo tanto en la detección de amenazas cibernéticas como en la respuesta a los ataques. En términos más generales, los patrones del gráfico 2 sugieren que es probable que la IA amplíe el alcance y el tamaño de las unidades de ciberseguridad de los bancos centrales a través de un proceso combinado de automatización de tareas rutinarias e inversión en nuevas habilidades blandas.

4.2 Riesgos y desafíos

La creciente sofisticación y frecuencia de las amenazas cibernéticas, junto con el advenimiento de las herramientas de IA de generación, introducen nuevos riesgos y desafíos para los marcos de seguridad cibernética de las autoridades reguladoras y supervisoras.

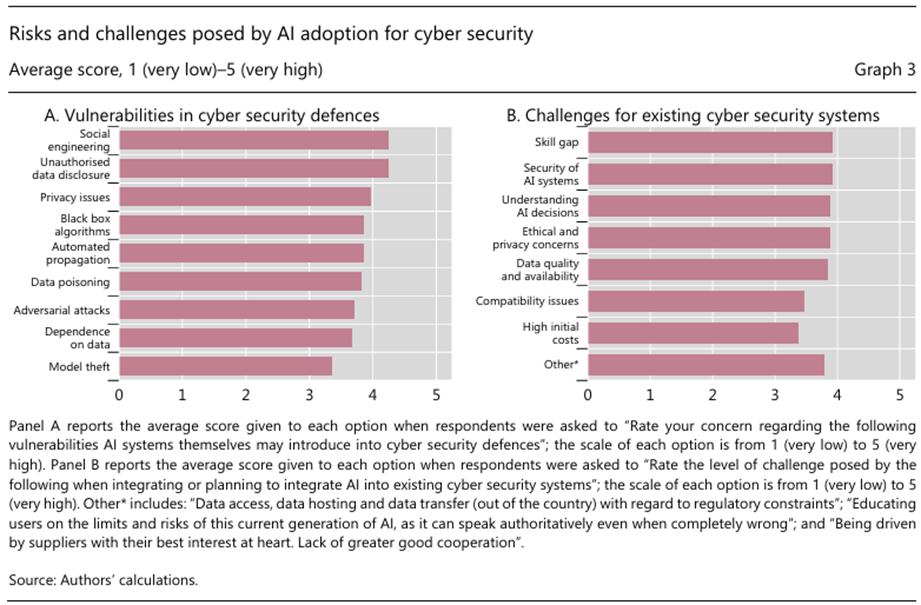

La encuesta pidió a los encuestados que calificaran sus preocupaciones con respecto a las diversas fuentes de vulnerabilidades que los sistemas de IA pueden introducir en las defensas de seguridad cibernética. Para todas las vulnerabilidades reportadas en el Gráfico 3.A, se pidió a los encuestados que asignaran una puntuación de 1 (nivel más bajo de preocupación) a 5 (nivel más alto de preocupación). Los encuestados están, en promedio, más preocupados por la «ingeniería social» y la «divulgación no autorizada de datos», que no son riesgos relacionados. Las herramientas de IA de la generación están permitiendo ciberataques cada vez más sofisticados, en particular a través de su capacidad para replicar voces o imágenes y crear deepfakes, con el objetivo final de extraer información o infiltrarse en las redes.10 Las implicaciones de un ataque de ingeniería social incluyen el acceso no autorizado a las redes internas de los bancos (con el posible bloqueo del sistema y demandas de pago de rescate), así como la divulgación involuntaria de datos confidenciales. Estos ataques pueden socavar la confianza en los bancos centrales y, en el extremo, poner en peligro la estabilidad financiera. Estas preocupaciones se extienden a todos los empleados de los bancos centrales, no solo a los de las unidades de TI, lo que subraya la necesidad de una política integral que eduque a todo el personal sobre las implicaciones de adoptar herramientas de IA genérica. Del mismo modo, la siguiente preocupación mejor valorada es «Problemas de privacidad» -el riesgo asociado a la posible exposición de datos sensibles-, seguida de «Algoritmos de caja negra» y «Propagación automatizada». Estas preocupaciones pueden reflejar temores de una «pérdida de control» tras la adopción de herramientas de IA de generación por parte de los operadores de ciberseguridad, ya que las decisiones tomadas por modelos autónomos de IA pueden ser difíciles de entender y explicar. En general, cuando se les pidió que evaluaran el riesgo asociado con la implementación de la IA de generación para la seguridad cibernética en una escala de 1 (muy bajo) a 10 (muy alto), el 96% de los encuestados respondió con 5 o más.

La encuesta también pidió a los encuestados que calificaran los diferentes desafíos que surgen del uso de la IA genérica para la seguridad cibernética en una escala de 1 (la más baja) a 5 (la más alta). En el gráfico 3.B se informa de cómo los bancos centrales evalúan los retos que suelen surgir en la integración (o la integración prevista) de la IA genérica en los sistemas de ciberseguridad existentes. Para la mayoría de las opciones, los bancos centrales ven desafíos sustanciales. En particular, la «brecha de habilidades» (el déficit de personas competentes tanto en programación de IA como en seguridad cibernética) recibe la puntuación promedio más alta. En la siguiente sección se volverá a examinar este desafío con más detalle.

Otros desafíos incluyen cuestiones relacionadas con la gestión de datos y la transparencia. Esto incluye «Seguridad de los sistemas de IA» (garantizar que los sistemas de IA estén protegidos contra las vulnerabilidades y el uso indebido por parte de los atacantes), «Comprender las decisiones de la IA» (la dificultad para interpretar y comprender los procesos de toma de decisiones de la IA, especialmente con algoritmos complejos), «Preocupaciones éticas y de privacidad» (abordar las implicaciones éticas y los problemas de privacidad que surgen del uso de la IA en la vigilancia y otras funciones de seguridad) y «Calidad y disponibilidad de los datos» (desafíos relacionados con la disponibilidad de datos relevantes y de alta calidad necesarios para entrenar modelos de IA de manera efectiva).

5. Inversiones en TI y capital humano

La mayoría de los bancos centrales han aumentado significativamente su presupuesto anual para la inversión en ciberseguridad desde 2020 (Doerr et al (2022)). El auge de la IA gen refuerza esta tendencia y exige una actualización urgente de las competencias, tanto a través de iniciativas de formación para el personal existente como de la contratación de nuevos empleados.

Al discutir la relación entre el nivel de capital humano y la integración de la IA en generación con la ciberseguridad, surgen dos dimensiones importantes de análisis.

El primero se refiere a todos los empleados del banco central, centrándose específicamente en la adopción de herramientas de IA de generación. Esta adopción puede verse obstaculizada por las insuficientes habilidades tecnológicas de la fuerza laboral existente o incluso podría verse impedida por prácticas internas debido a preocupaciones relacionadas con la protección de datos y la privacidad. El segundo se relaciona más directamente con el capital humano dentro de las divisiones de TI de los bancos centrales, específicamente en lo que respecta a la seguridad cibernética.

En cuanto a la primera dimensión, la encuesta preguntó si los bancos centrales han habilitado o planean permitir que su personal acceda a aplicaciones de IA genéricas basadas en la nube (por ejemplo, ChatGPT). La mayoría de los encuestados respondieron afirmativamente, aunque con ciertas restricciones (por ejemplo, prohibir el envío de información corporativa). Entre los encuestados, el 13% informó que actualmente no tiene esta capacidad, pero planea implementarla pronto, mientras que el 9% indicó que no tiene planes para permitir el acceso. Solo el 3% de los encuestados ha permitido el acceso sin restricciones a las aplicaciones basadas en la nube para el personal.

En términos generales, los expertos en ciberseguridad están preocupados por la preparación y la capacidad del personal actual para integrar y utilizar eficazmente los sistemas de IA. Cuando se les preguntó al respecto, el 40% de los encuestados expresó una preocupación alta o extrema, el 35% una preocupación moderada, un 15% una preocupación leve y un encuestado informó no estar preocupado. Una implicación es que la introducción de prácticas internas y políticas regulatorias comunes podría ser necesaria para una adopción segura y generalizada de las herramientas de IA genética en los bancos centrales.

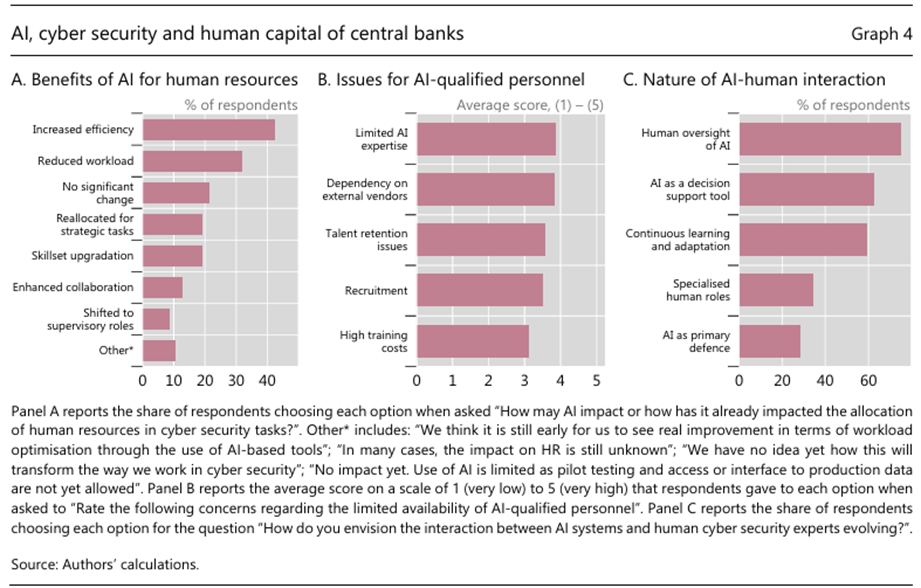

Una segunda cuestión distinta se refiere a las inversiones en TI y la gestión del capital humano empleado en las unidades de ciberseguridad de los bancos centrales. El gráfico 4.A muestra que el beneficio más mencionado de la IA genérica es el «aumento de la eficiencia», lo que pone de manifiesto la capacidad del personal de ciberseguridad para utilizar herramientas que faciliten una toma de decisiones y respuestas más rápidas. Otra ventaja clave es la «reducción de la carga de trabajo», atribuida a la automatización de numerosos procesos que disminuyen la carga del personal de seguridad cibernética. Algunos bancos centrales han informado de que «no hay cambios significativos», lo que indica que la IA de la generación se ha integrado sin cambios significativos en la asignación de recursos humanos. Se otorgaron calificaciones más bajas a la «mejora del conjunto de habilidades» (la necesidad de mejorar las habilidades dentro de la fuerza laboral de seguridad cibernética para administrar e interactuar de manera efectiva con las herramientas de IA) y «Reasignación para tareas estratégicas» (con la IA asumiendo tareas rutinarias, liberando así a los recursos humanos para concentrarse en esfuerzos de seguridad cibernética más estratégicos). En general, mientras que la IA de la generación puede proporcionar beneficios en términos de tareas rutinarias, las unidades de ciberseguridad se están centrando simultáneamente en adquirir nuevas habilidades para su personal actual y reasignarlas hacia iniciativas de ciberseguridad más estratégicas.

Persiste la preocupación por la escasez de personal cualificado en IA. Para una serie de preocupaciones enumeradas, se pidió a los encuestados que asignaran una puntuación del 1 al 5, siendo 1 el más bajo y 5 el más alto (gráfico 4.B). La «experiencia limitada en IA» surgió como la preocupación mejor valorada, lo que subraya la importancia de la retención y el reclutamiento de talento en la gestión de personal. La segunda mayor preocupación es la «Dependencia de proveedores externos», lo que indica una dependencia sustancial de proveedores externos para soluciones de IA, que también puede ser una función de personal interno inadecuado. Ya se ha reconocido que la dependencia de los servicios en la nube es crucial para la gestión del riesgo cibernético en los bancos centrales, especialmente en las economías avanzadas (Doerr et al (2022)). La IA de la generación da un nuevo impulso a estas preocupaciones (Araujo et al (2024)).

Por último, la encuesta explora las opiniones de los bancos centrales sobre la colaboración entre los sistemas de IA y los expertos humanos en ciberseguridad. La mayoría de los encuestados reconoce que la IA es una oportunidad, aunque requiere supervisión humana (gráfico 4.C). La IA de la generación se considera principalmente una herramienta para apoyar a los expertos humanos, mejorando su productividad en lugar de servir como el mecanismo de defensa principal y autónomo. Los expertos en unidades de ciberseguridad también coinciden en el hecho de que los humanos entrenarán y actualizarán continuamente los sistemas de IA, al tiempo que utilizan su aprendizaje continuo. En general, estos patrones sugieren una relación complementaria entre las capacidades humanas y las de la IA.

6. Perspectivas futuras y perspectivas regulatorias

Hasta ahora, hemos analizado los problemas relacionados con la adopción de la IA gen en las prácticas de ciberseguridad de los bancos centrales, proporcionando principalmente una instantánea de la situación actual. La encuesta también preguntó sobre la evaluación de los bancos centrales de los aspectos futuros de la gestión del riesgo cibernético y su perspectiva sobre las acciones que se pueden proponer para incorporar adecuadamente la IA genética en sus operaciones.

En los últimos años, los bancos centrales han invertido significativamente en varias áreas relacionadas con la ciberseguridad. Estos incluyen el desarrollo de planes de respuesta a incidentes en caso de ataques cibernéticos (por ejemplo, con ejercicios internos para simular ataques), el suministro de marcos de gestión de riesgos para la seguridad cibernética (por ejemplo, mediante la realización de pruebas de estrés cibernéticas) y la recopilación de información sobre ataques cibernéticos a instituciones financieras. En términos más generales, se ha producido un cambio de un enfoque basado en el cumplimiento a un enfoque de gestión de riesgos y resiliencia.

Una pregunta abierta es si la IA genética cambiará las estrategias y enfoques generales de la ciberseguridad en los próximos años. Los resultados de la encuesta indican que la mayoría de los encuestados no prevé cambios importantes. Más allá de los cambios esperados debido a la adopción de la nueva tecnología, el panorama en evolución confirma la tendencia actual hacia un enfoque de gestión de riesgos y resiliencia para la seguridad cibernética. La mayoría de los bancos centrales anticipan que los sistemas de IA de generación conducirán a un cambio hacia la proactividad, es decir, pasar de una postura reactiva a una proactiva en la predicción y neutralización de amenazas antes de que se manifiesten. También se espera que la IA proporcione una defensa más personalizada de las redes y sistemas, basada en el comportamiento de los usuarios y los perfiles de las empresas, junto con una evaluación dinámica de riesgos para detectar y defenderse de nuevas amenazas. Con todo, se prevé que las herramientas de IA de generación respalden las funciones de gestión de riesgos y mejoren los protocolos existentes, sin alterar el reciente cambio hacia una mejora de la resiliencia cibernética, es decir, la capacidad de los bancos centrales para prever, adaptarse y recuperarse rápidamente de los incidentes cibernéticos mientras continúan con sus operaciones esenciales.

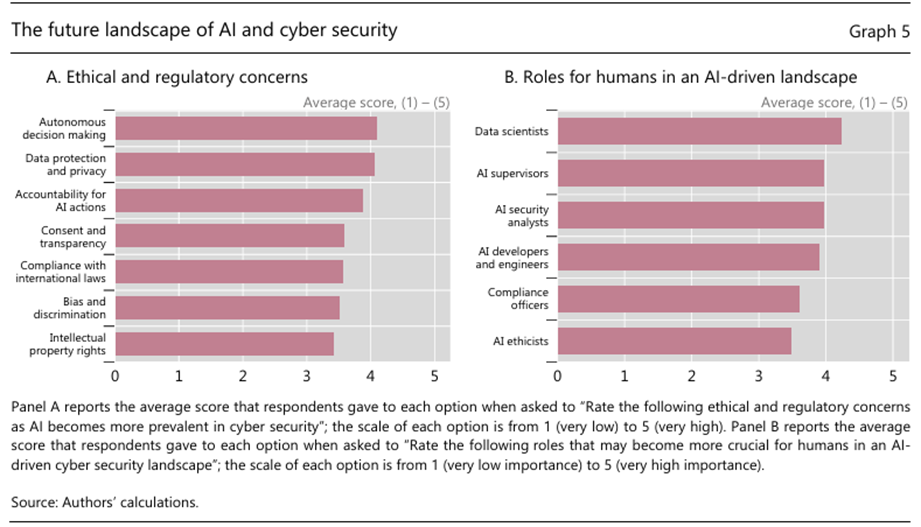

La encuesta también pidió a los participantes que calificaran varias preocupaciones éticas y regulatorias en caso de que la IA genética se integre cada vez más con la seguridad cibernética. La escala de calificación oscila entre 1 y 5, siendo 1 la preocupación más baja y 5 la más alta. El gráfico 5.A muestra que las principales preocupaciones identificadas son la «toma de decisiones autónoma», que implica establecer límites a las decisiones que la IA puede tomar de forma independiente, y la «protección de datos y la privacidad», que enfatiza la importancia de mantener normas estrictas de protección de datos y privacidad en medio de las capacidades mejoradas de análisis de datos de la IA. Otra cuestión importante que se destaca es la «Rendición de cuentas de las acciones de IA» (establecimiento de directrices para definir la responsabilidad de las decisiones impulsadas por la IA, en particular cuando dan lugar a resultados adversos). «Cumplimiento de las leyes internacionales» y «Consentimiento y transparencia» se consideran cuestiones relativamente menos urgentes en este momento, probablemente debido a la continua adaptación y refinamiento de las regulaciones para mantenerse al día con el progreso tecnológico.

¿Qué roles serán cada vez más críticos para los trabajadores humanos a medida que se expanda el uso de la IA genérica? La encuesta pidió a los participantes que calificaran diferentes aspectos en una escala de 1 (el más bajo) a 5 (el más alto). Se espera que los «científicos de datos», con su experiencia en la comprensión e interpretación de datos integrales para los sistemas de IA, así como en el perfeccionamiento de los procesos de aprendizaje de la IA, desempeñen un papel importante (gráfico 5.B). A esta categoría le siguen de cerca los «supervisores de IA» (que garantizan que las operaciones de IA se adhieran a los objetivos de la organización y las normas éticas), los «analistas de seguridad de IA» (especialistas en la protección de los sistemas de IA contra violaciones o manipulaciones por parte de entidades maliciosas) y los «desarrolladores e ingenieros de IA» (los expertos técnicos responsables de crear, mantener y mejorar los algoritmos y sistemas de IA diseñados para la ciberseguridad). Estos resultados confirman la importancia de la experiencia humana para la correcta adopción y uso de las herramientas de IA de generación para la ciberseguridad. También se hace hincapié en los profesionales que garantizan el cumplimiento de los principios éticos y las normas sociales, así como en los responsables de cumplimiento que verifican que las prácticas de ciberseguridad de la IA cumplen con los estándares legales, reglamentarios y del sector.

7. Conclusión

Los ataques cibernéticos son cada vez más frecuentes y evolucionan en complejidad y sofisticación. Al mismo tiempo, hay cambios significativos en la tecnología generados por los rápidos desarrollos en los sistemas de IA de generación.

Al realizar una encuesta personalizada a los líderes de ciberseguridad de los bancos centrales en el foro GCRG administrado por la CRCC en enero de 2024, investigamos el estado de la adopción de las herramientas de IA gen, identificamos los beneficios y riesgos percibidos asociados con su uso para la ciberseguridad y destacamos los desafíos percibidos y las perspectivas futuras desde el punto de vista de los bancos centrales. Si bien la regulación de la IA aún no está completamente desarrollada (Aldasoro et al (2024b)), existe un fuerte consenso sobre la adopción de reglas comunes para el uso de la IA para la ciberseguridad, y un reconocimiento de que se necesitan nuevas formas de cooperación a nivel de los bancos centrales. Dichos esfuerzos de colaboración deben abordar el establecimiento de nuevos estándares de protección de datos para garantizar la implementación responsable de la IA genérica y, lo que es más importante, abordar el problema de la «brecha de habilidades» entre el personal humano.

El BPI apoya los esfuerzos de seguridad cibernética de los bancos centrales y la cooperación global a través de la CRCC. Establecido en 2019, el CRCC desempeña un papel fundamental en la futura integración de la IA de generación para la seguridad cibernética. Un enfoque estructurado para el intercambio de conocimientos, la colaboración y la formación de capital humano es de primera importancia para hacer frente a los desafíos futuros. Uno de los proyectos clave es el foro GCRG, que incluye a los CISO de los bancos centrales miembros del BPI, que representan el liderazgo en seguridad cibernética en la comunidad mundial de bancos centrales. Este grupo es fundamental para abordar los desafíos que presenta la adopción de tecnologías de IA. Otras iniciativas de CRCC incluyen una plataforma global de colaboración de resiliencia cibernética con más de 300 profesionales activos de seguridad cibernética de la comunidad de bancos centrales. Esta plataforma y esta comunidad están preparadas para convertirse en un foro central de colaboración e intercambio de conocimientos sobre el tema de los desafíos y la adopción de la IA.

El CRCC también lidera el proyecto de Evaluaciones de Resiliencia Cibernética. Su objetivo es proporcionar a los bancos centrales un marco común para evaluar su postura de ciber resiliencia y mejorar sus prácticas de ciber resiliencia en la prestación de servicios empresariales críticos. La CRCC ha realizado evaluaciones de resiliencia cibernética en varios bancos centrales miembros del BPI y ha proporcionado un punto de referencia mundial para la comunidad de bancos centrales. Los bancos centrales ahora pueden comparar su postura de resiliencia cibernética con el índice de referencia y tomar decisiones de inversión informadas con respecto a la seguridad cibernética. Además, el CRCC también lleva a cabo varios eventos comunitarios, como seminarios anuales de seguridad cibernética y ejercicios de alcance cibernético. Estos eventos ayudan a mantener a la comunidad mundial de ciberseguridad de los bancos centrales comprometida con los problemas y amenazas emergentes de ciberseguridad (como la adopción de la IA), garantizando así la preparación operativa.

La cooperación y el intercambio de información son fundamentales para reducir colectivamente el riesgo cibernético y prevenir y contener los incidentes cibernéticos graves. La importancia de la cooperación aumentará aún más con la adopción y el desarrollo de sistemas de IA de alta generación.

Referencias

Aldasoro, I, S Doerr, L Gambacorta y D Rees (2024a): «El impacto de la inteligencia artificial en la producción y la inflación», Documentos de Trabajo del BPI, n.º 1179, abril.

Aldasoro, I, J Frost, L Gambacorta, T Leach y D Whyte (2020): «Cyber risk in the financial sector», SUERF Policy Notes, No. 206, noviembre.

Aldasoro, I, L Gambacorta, P Giudici y T Leach (2022): «Los impulsores del riesgo cibernético», Journal of Financial Stability, vol 60, junio.

Aldasoro, I, L Gambacorta, A Korinek, V Shreeti y M Stein (2024b): «Sistema financiero inteligente: cómo la IA está transformando las finanzas», Documentos de trabajo del BPI, de próxima publicación.

Araujo, D, G Bruno, J Marcucci, R Schmidt y B Tissot (2022): «Machine learning in central banking», IFC Bulletins, No. 57, noviembre.

Araujo, D, S Doerr, L Gambacorta y B Tissot (2024): «La inteligencia artificial en la banca central», Boletines del BPI, No. 84, enero.

Comité de Supervisión Bancaria de Basilea (2018): Ciber resiliencia: gama de prácticas, diciembre.

——— (2021): «Newsletter sobre ciberseguridad», septiembre.

Boissay, F, G Cornelli, S Doerr y J Frost (2022): «La escalabilidad de la cadena de bloques y la fragmentación de las criptomonedas», Boletines del BPI, No. 56, junio.

Brynjolfsson, E, D Li y L Raymond (2023): «Generative AI at work» (La IA generativa en el trabajo), NBER Working Papers, n.º 31161.

Doerr, S, L Gambacorta y J Serena Garralda (2021): «Big data and machine learning in central banking», BIS Working Papers, No. 930, marzo.

Doerr, S, L Gambacorta, T Leach, B Legros y D Whyte (2022): «Cyber risk in central banking», BPI Working Papers, No. 1039, septiembre.

Grupo de Estrategia Empresarial y Asociación de Seguridad de Sistemas de Información (2020): La vida y los tiempos de los profesionales de la ciberseguridad 2020, julio.

Falade, P (2023) «Decodificando el panorama de amenazas: ChatGPT, FraudGPT y WormGPT en ataques de ingeniería social», arXiv:2310.05595.

Felten, E, M Raj y R Seamans (2021): «Exposición ocupacional, industrial y geográfica a la inteligencia artificial: un nuevo conjunto de datos y sus usos potenciales», Strategic Management Journal, vol. 42, n.º 12, pp. 2195-217.

Consejo de Estabilidad Financiera (2020): Prácticas efectivas para la respuesta y recuperación de incidentes cibernéticos: informe final, octubre.

G7 (2016): G7 elementos fundamentales de la ciberseguridad para el sector financiero, octubre.

Hitaj, D, G Pagnotta, F De Gaspari, D Ruko, B Hitaj, L Mancini y F Pérez-Cruz (2024): «¿Confías en tu modelo? Amenazas emergentes de malware en el ecosistema de aprendizaje profundo», arXiv:2403.03593v1.

Hitaj, D, G Pagnotta, B Hitaj, L Mancini y F Pérez-Cruz (2022): «MaleficNet: ocultación de malware en redes neuronales profundas mediante la codificación de canales de espectro ensanchado», en V Atluri, R Di Pietro, C Jensen y W Meng (eds), Computer Security – ESORICS 2022, Lecture Notes in Computer Science, vol 13556, Springer, Cham.

Improta, C (2024): «Programas de envenenamiento por código no reparador: preocupaciones de seguridad del código generado por IA», arXiv:2403.06675v1.

Kashyap, A y A Wetherilt (2019): «Algunos principios para regular el riesgo cibernético», AEA Papers and Proceedings, vol 109, mayo, pp 482-7.

McKinsey (2023): El potencial económico de la IA generativa: la próxima frontera de la productividad, informe McKinsey Digital, junio.

Neupane, S, I Fernandez, S Mittal y S Rahimi (2023): «Impactos y riesgos de la tecnología de IA generativa en la ciberdefensa», 10.48550/arXiv.2306.13033.

Noy, S y W Zhang (2023): «Evidencia experimental sobre los efectos de la productividad de la inteligencia artificial generativa», Science, vol 381, no 6654, julio, pp 187-92.

Peng, S, W Swiatek, A Gao, P Cullivan y H Chang (2024): «Revolución de la IA en el chat bot: evidencia de un experimento controlado aleatorio», mimeo.

Departamento del Tesoro de EE. UU. (2024): Gestión de los riesgos de ciberseguridad específicos de la inteligencia artificial en el sector de los servicios financieros, marzo.

Zhu, B, N Mu, J Jiao y D Wagner (2024) «Seguridad de la IA generativa: desafíos y contramedidas», arXiv:2402.12617v1.

Publicado originalmente: https://www.bis.org/publ/bppdf/bispap145.pdf